ąÆ čĆčāą▒čĆąĖą║čā "ąĀąĄčłąĄąĮąĖčÅ ą║ąŠčĆą┐ąŠčĆą░čéąĖą▓ąĮąŠą│ąŠ ą║ą╗ą░čüčüą░" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣

ąöą░ąĮąĮčŗąĄ čüčéą░ą╗ąĖ ą║čĆąĖčéąĖč湥čüą║ąĖ ą▓ą░ąČąĮčŗą╝ čĆąĄčüčāčĆčüąŠą╝ ą┐čĆą░ą║čéąĖč湥čüą║ąĖ ą┤ą╗čÅ ą▓čüąĄčģ ą░čüą┐ąĄą║č鹊ą▓ č湥ą╗ąŠą▓ąĄč湥čüą║ąŠą╣ ąČąĖąĘąĮąĖ, ąĖ čü čĆą░ąĘą▓ąĖčéąĖąĄą╝ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ čāą▓ąĄą╗ąĖčćąĖą▓ą░ąĄčéčüčÅ ąĖčģ ąŠą▒čŖąĄą╝. ąĪąŠą│ą╗ą░čüąĮąŠ ą┐čĆąŠą│ąĮąŠąĘą░ą╝ IDC, ą║ 2025 ą│. ąŠą▒čŖąĄą╝ ąĮą░ą║ąŠą┐ą╗ąĄąĮąĮčŗčģ ą┤ą░ąĮąĮčŗčģ ą▓ąŠ ą▓čüąĄą╝ ą╝ąĖčĆąĄ ą▓čŗčĆą░čüč鹥čé ą┤ąŠ ąĘąĮą░č湥ąĮąĖčÅ ą▓ 163 ąŚą▒ą░ą╣čé (ąĘąĄčéčéą░ą▒ą░ą╣čé), čćč鹊 ą▓ ą┤ąĄčüčÅčéčī čĆą░ąĘ ą▒ąŠą╗čīčłąĄ, č湥ą╝ ą▓ 2016 ą│. ą¦č鹊ą▒čŗ čģčĆą░ąĮąĖčéčī ąĮą░ DVD čŹč鹊čé ą║ąŠą╗ąŠčüčüą░ą╗čīąĮčŗą╣ ąŠą▒čŖąĄą╝ ąĖąĮč乊čĆą╝ą░čåąĖąĖ, ą┐ąŠčéčĆąĄą▒čāąĄčéčüčÅ 40 čéčĆą╗ąĮ čćąĖčüčéčŗčģ ą┤ąĖčüą║ąŠą▓. ąØąŠ ą▒čāą┤ąĄčé ą╗ąĖ čŹčéą░ ąĖąĮč乊čĆą╝ą░čåąĖčÅ ąĘą░ą┐ąĖčüą░ąĮą░ ąĮą░ ą┤ąĖčüą║ąŠą▓čŗčģ čģčĆą░ąĮąĖą╗ąĖčēą░čģ ąĖą╗ąĖ ą┐ąŠą┐čāą╗čÅčĆąĮčŗą╝ąĖ čüčéą░ąĮčāčé ą┤čĆčāą│ąĖąĄ čüąĖčüč鹥ą╝čŗ čģčĆą░ąĮąĄąĮąĖčÅ ą┤ą░ąĮąĮčŗčģ? ąś ą┐ąŠč湥ą╝čā ą▒ąĖąĘąĮąĄčü ą▓čüąĄ ą▒ąŠą╗čīčłąĄ ąĘą░ą│ą╗čÅą┤čŗą▓ą░ąĄčéčüčÅ ąĮą░ SDS-čĆąĄčłąĄąĮąĖčÅ, ąĮąŠ ą┐čĆąĖ čŹč鹊ą╝ ąĮąĄ čüą┐ąĄčłąĖčé ąŠčéą║ą░ąĘčŗą▓ą░čéčīčüčÅ ąŠčé čéčĆą░ą┤ąĖčåąĖąŠąĮąĮčŗčģ ąĪąźąö?

Data has become a critical resource in all business areas and itŌĆÖs amount is increasing through time and technology development. Data creation will swell to a total of 163 zettabytes (ZB) by 2025 ŌĆō a ten-fold increase in todayŌĆÖs numbers, according to a new whitepaper from IDC. One would need up to 40 trillions of disks, to store this amount of information on DVD. What is the future of data storage: will new data storage systems take place of regular disk storages? Though business seems to be attracted by SDS-solutions, companies still use traditional data storage systems.

ąØą░čćąĖąĮą░čÅ čü ą┐ąĄčĆą▓ąŠą│ąŠ ąČąĄčüčéą║ąŠą│ąŠ ą┤ąĖčüą║ą░, ą┐ąŠčÅą▓ąĖą▓čłąĄą│ąŠčüčÅ ą▓ 1956 ą│., ąĖ ą┤ąŠ ąĮą░čłąĖčģ ą┤ąĮąĄą╣ čüąĖčüč鹥ą╝čŗ čģčĆą░ąĮąĄąĮąĖčÅ ą┤ą░ąĮąĮčŗčģ ą┐čĆąĄč鹥čĆą┐ąĄą╗ąĖ ą▒ąŠą╗čīčłąŠąĄ ą║ąŠą╗ąĖč湥čüčéą▓ąŠ ąĖąĘą╝ąĄąĮąĄąĮąĖą╣ ą║ą░ą║ ą▓ č乊čĆą╝-čäą░ą║č鹊čĆąĄ, čéą░ą║ ąĖ ą▓ č鹥čģąĮąŠą╗ąŠą│ąĖąĖ čģčĆą░ąĮąĄąĮąĖčÅ ą▓ čåąĄą╗ąŠą╝.

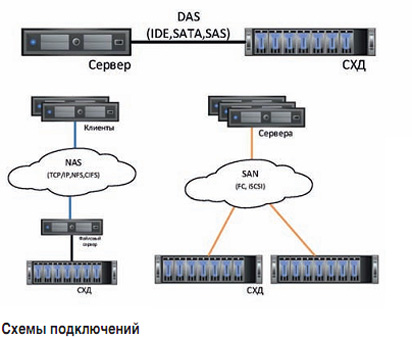

ą¤ąĄčĆą▓čŗąĄ ą┤ąĖčüą║ąĖ ąĖ ą╝ą░čüčüąĖą▓čŗ ą┐ąŠą┤ą║ą╗čÄčćą░ą╗ąĖčüčī ąĮą░ą┐čĆčÅą╝čāčÄ ą║ čüąĄčĆą▓ąĄčĆčā ąĖ čĆą░ą▒ąŠčéą░ą╗ąĖ č鹊ą╗čīą║ąŠ čü ąĮąĖą╝. ąóą░ą║ą░čÅ čüčģąĄą╝ą░ ąĮą░ąĘčŗą▓ą░ą╗ą░čüčī DAS (Direct-attached Storage). ąöą░ąĮąĮą░čÅ čüąĖčüč鹥ą╝ą░ ą▒čŗą╗ą░ ą┤ąĄčłąĄą▓ąŠą╣, ąŠčéąĮąŠčüąĖč鹥ą╗čīąĮąŠ ąĮą░ą┤ąĄąČąĮąŠą╣ ąĖ ąŠą▒ąĄčüą┐ąĄčćąĖą▓ą░ą╗ą░ ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗą╣ čāčĆąŠą▓ąĄąĮčī ą▒čŗčüčéčĆąŠą┤ąĄą╣čüčéą▓ąĖčÅ ąŠą┐ąĄčĆą░čåąĖą╣ ą▓ą▓ąŠą┤ą░-ą▓čŗą▓ąŠą┤ą░. ąØąŠ ą▒čŗą╗ ąŠą┤ąĖąĮ ą▒ąŠą╗čīčłąŠą╣ ą╝ąĖąĮčāčü ŌĆō čŹčéąĖ čüąĖčüč鹥ą╝čŗ ąĮąĄ ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░ą╗ąĖ čüąŠą▓ą╝ąĄčüčéąĮąŠą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ąĄą╝ą║ąŠčüčéąĖ čģčĆą░ąĮąĄąĮąĖčÅ čĆą░ąĘąĮčŗą╝ąĖ čüąĄčĆą▓ąĄčĆą░ą╝ąĖ, čćč鹊 ą▒čŗą╗ąŠ ąŠč湥ąĮčī ąĘą░čéčĆą░čéąĮąŠ ąĖ ąĮąĄą┐čĆą░ą║čéąĖčćąĮąŠ. ąØąĖ ąŠ ą║ą░ą║ąŠą╣ čāą┤ąŠą▒ąĮąŠą╣ ą╝ą░čüčłčéą░ą▒ąĖčĆčāąĄą╝ąŠčüčéąĖ ąĮąĄ ą╝ąŠą│ą╗ąŠ ą▒čŗčéčī ąĖ čĆąĄčćąĖ.

ąĪą╗ąĄą┤čāčÄčēąĖą╝ čéąĖą┐ąŠą╝ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ čüąĄčĆą▓ąĄčĆąŠą▓ ą║ ąĪąźąö čüčéą░ą╗ NAS (Network Attached Storage), ą┐čĆąĄą┤čüčéą░ą▓ą╗ąĄąĮąĮčŗą╣ ą▓ ąĮą░čćą░ą╗ąĄ 1980-čģ ą│ą│. ą¤ąĄčĆą▓ąŠąĮą░čćą░ą╗čīąĮąŠ ą┤ąŠčüčéčāą┐ ąŠčüčāčēąĄčüčéą▓ą╗čÅą╗čüčÅ ą╝ąĄąČą┤čā ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ąĖ ą╝ą░čłąĖąĮą░ą╝ąĖ čüąĖčüč鹥ą╝čŗ UNIX. ąÆ ą┤ą░ąĮąĮąŠą╣ čüčģąĄą╝ąĄ ą┤ąĖčüą║ąĖ ąĖ ą╝ą░čüčüąĖą▓čŗ ą┐ąŠą┤ą║ą╗čÄčćą░čÄčéčüčÅ č湥čĆąĄąĘ ą╗ąŠą║ą░ą╗čīąĮčāčÄ ą▓čŗčćąĖčüą╗ąĖč鹥ą╗čīąĮčāčÄ čüąĄčéčī Ethernet (Fast Ethernet, Gigabit Ethernet), čćą░čēąĄ ą▓čüąĄą│ąŠ ą┐ąŠ ą┐čĆąŠč鹊ą║ąŠą╗ą░ą╝ TCP/IP ą┤ą╗čÅ ą┐ąĄčĆąĄą┤ą░čćąĖ ą┤ą░ąĮąĮčŗčģ, SMB (CIFS) ąĖ NFS ŌĆō ą┤ą╗čÅ čāą┤ą░ą╗ąĄąĮąĮčŗčģ čäą░ą╣ą╗ąŠą▓čŗčģ čüąĄčĆą▓ąĖčüąŠą▓.

ąöą░ąĮąĮą░čÅ čüčģąĄą╝ą░ čāąČąĄ ą▒ąŠą╗ąĄąĄ ą│ąĖą▒ą║ą░čÅ ąĖ ą╗ąĄą│ą║ąŠ ą╝ą░čüčłčéą░ą▒ąĖčĆčāąĄčéčüčÅ. ąÜ ą┐ą╗čÄčüą░ą╝ čéą░ą║ąČąĄ ą╝ąŠąČąĮąŠ ąŠčéąĮąĄčüčéąĖ ą┤ąĄčłąĄą▓ąĖąĘąĮčā ąĖ ą┤ąŠčüčéčāą┐ąĮąŠčüčéčī ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗčģ čĆąĄčüčāčĆčüąŠą▓ ą┤ą╗čÅ ą▓čüąĄčģ čüąĄčĆą▓ąĄčĆąŠą▓ ąĖ ą║ąŠą╝ą┐čīčÄč鹥čĆąŠą▓ ą║ąŠą╝ą┐ą░ąĮąĖąĖ. ąØąŠ čéą░ą║ąŠą╣ ą▓ą░čĆąĖą░ąĮčé ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░ąĄčé č鹊ą╗čīą║ąŠ čäą░ą╣ą╗ąŠą▓čŗą╣ ą┤ąŠčüčéčāą┐ ą║ ą┤ą░ąĮąĮčŗą╝, čćč鹊 ą┐čĆąĖą▓ąŠą┤ąĖčé ą║ ą▒ąŠą╗čīčłąĖą╝ ą┐ąŠč鹥čĆčÅą╝ ą▓ ą▒čŗčüčéčĆąŠą┤ąĄą╣čüčéą▓ąĖąĖ ąĖ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ, č湥ą╝ čā ą╗ąŠą║ą░ą╗čīąĮčŗčģ ą┤ąĖčüą║ąŠą▓ ąĖą╗ąĖ ą▒ą╗ąŠčćąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░.

ąØąĄąĘą░ą▓ąĖčüąĖą╝ąŠ ąŠčé NAS čĆą░ąĘčĆą░ą▒ą░čéčŗą▓ą░ą╗ą░čüčī ąĄčēąĄ ąŠą┤ąĮą░ čüčģąĄą╝ą░ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ŌĆō SAN (Storage Area Network). SAN ŌĆō čŹč鹊 ą┐ąŠ čüčāčéąĖ ą▓čŗą┤ąĄą╗ąĄąĮąĮą░čÅ čüąĄčéčī ą┤ą╗čÅ ą▒ą╗ąŠčćąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ ą║ ą┤ą░ąĮąĮčŗą╝. ąØą░ čüąĄčĆą▓ąĄčĆąĄ SAN ą┤ąĖčüą║ ą▓čŗą│ą╗čÅą┤ąĖčé ą║ą░ą║ ąŠą▒čŗčćąĮčŗą╣ ą╗ąŠą║ą░ą╗čīąĮčŗą╣ ą┤ąĖčüą║. ąØą░ąĖą▒ąŠą╗ąĄąĄ čĆą░čüą┐čĆąŠčüčéčĆą░ąĮąĄąĮąĮčŗą╝ąĖ ą┐čĆąŠč鹊ą║ąŠą╗ą░ą╝ąĖ ą┤ą╗čÅ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ čÅą▓ą╗čÅčÄčéčüčÅ FibreChannel ąĖ iSCSI. ąØą░ čüąĄčĆą▓ąĄčĆąĄ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ ąĖą╝ąĄčéčī čüą┐ąĄčåąĖą░ą╗čīąĮčāčÄ ą║ą░čĆčéčā ŌĆō HBA (Host Bus Adapter): ąŠąĮą░ čÅą▓ą╗čÅąĄčéčüčÅ ą▓čģąŠą┤ąĮąŠą╣ č鹊čćą║ąŠą╣ ą┤ą╗čÅ ą▓čüąĄčģ ą▓ąĮąĄčłąĮąĖčģ ą┤ąĖčüą║ąŠą▓ ąĖ č湥čĆąĄąĘ ąĄąĄ ą┐ąŠčĆčéčŗ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖąĄ čü ą╝ą░čüčüąĖą▓ąŠą╝. ąæą╗ąŠą║ąĖ ą┤ą░ąĮąĮčŗčģ ąĖ ą║ąŠą╝ą░ąĮą┤čŗ SCSI ąŠą▒ąŠčĆą░čćąĖą▓ą░čÄčéčüčÅ ą▓ ą┐ą░ą║ąĄčéčŗ FC ąĖą╗ąĖ IP ą┤ą╗čÅ iSCSI, ą░ ąĘą░č鹥ą╝ ą┐ąĄčĆąĄą┤ą░čÄčéčüčÅ ąĮą░ ą╝ą░čüčüąĖą▓.

ąÜ ą┐ą╗čÄčüą░ą╝ čéą░ą║ąŠą╣ čüčģąĄą╝čŗ ą╝ąŠąČąĮąŠ ąŠčéąĮąĄčüčéąĖ čüą░ą╝ ą┐ąŠ čüąĄą▒ąĄ ą▒ą╗ąŠčćąĮčŗą╣ ą┤ąŠčüčéčāą┐ ą║ čāčüčéčĆąŠą╣čüčéą▓ą░ą╝ ŌĆō čŹč鹊 ą┤ą░ąĄčé ąĘąĮą░čćąĖč鹥ą╗čīąĮčŗą╣ ą▓čŗąĖą│čĆčŗčł ą▓ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ ąĖ ą▒čŗčüčéčĆąŠą┤ąĄą╣čüčéą▓ąĖąĖ. ąöą░ąĮąĮą░čÅ čüčģąĄą╝ą░ čéą░ą║ąČąĄ ąĖą╝ąĄąĄčé ąŠčéą╗ąĖčćąĮčāčÄ ą╝ą░čüčłčéą░ą▒ąĖčĆčāąĄą╝ąŠčüčéčī ąĖ ąŠą│čĆąŠą╝ąĮčŗąĄ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ą┤ą╗čÅ čĆą░čüčłąĖčĆąĄąĮąĖčÅ. ąÜ čüąŠąČą░ą╗ąĄąĮąĖčÄ, čŹč鹊 čĆąĄčłąĄąĮąĖąĄ ąĮąĄ čÅą▓ą╗čÅąĄčéčüčÅ ą┤ąĄčłąĄą▓čŗą╝. FibreChannel ąŠą▒čģąŠą┤ąĖčéčüčÅ ą┤ąŠčĆąŠąČąĄ, č湥ą╝ iSCSI, ąĮąŠ čÅą▓ą╗čÅąĄčéčüčÅ ą┐čĆąŠč鹊ą║ąŠą╗ąŠą╝ čü ą│ą░čĆą░ąĮčéąĖčĆąŠą▓ą░ąĮąĮąŠą╣ ą┐ąĄčĆąĄą┤ą░č湥ą╣ ą┤ą░ąĮąĮčŗčģ. ą¤čĆąĖ ą▓čüąĄą╝ čŹč鹊ą╝ iSCSI ąĮąĄ čāčüčéčāą┐ą░ąĄčé ą┐ąŠ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ, ą░ ą▓ ąĮąĄą║ąŠč鹊čĆčŗčģ ą╝ąŠą╝ąĄąĮčéą░čģ ą┤ą░ąČąĄ ą▓ą┐ąĄčĆąĄą┤ąĖ FibreChannel.

ąÆčüąĄ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĮčŗąĄ ą▓ą░čĆąĖą░ąĮčéčŗ ąĖą╝ąĄčÄčé ą┐čĆą░ą▓ąŠ ąĮą░ ąČąĖąĘąĮčī ą▓ čüąŠą▓čĆąĄą╝ąĄąĮąĮąŠą╝ ą╝ąĖčĆąĄ. ąØąĖ ąŠą┤ąĖąĮ ąĖąĘ ąĮąĖčģ ąĮąĄ ą║ą░ąĮčāą╗ ą▓ ą┐čĆąŠčłą╗ąŠąĄ, ą░ ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ ą┤ąŠ čüąĖčģ ą┐ąŠčĆ ąĖ ą┐čĆąŠą┤ąŠą╗ąČą░ąĄčé čĆą░ąĘą▓ąĖą▓ą░čéčīčüčÅ. ąÜą░ą║čāčÄ čüčģąĄą╝čā ą╗čāčćčłąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī? ąÆčüąĄ ąĘą░ą▓ąĖčüąĖčé ąŠčé čĆą░ąĘą╝ąĄčĆąŠą▓ ą▒ąĖąĘąĮąĄčüą░ ąĖ ąĄą│ąŠ ąĘą░ą┤ą░čć. ąØąŠ čćą░čēąĄ ą▓čüąĄą│ąŠ ą▓ čüąŠą▓čĆąĄą╝ąĄąĮąĮčŗčģ ą║ąŠą╝ą┐ą░ąĮąĖčÅčģ čüąŠą▓ą╝ąĄčēą░čÄčé ąĮąĄčüą║ąŠą╗čīą║ąŠ čüčģąĄą╝ ą┤ą╗čÅ ąŠą┤ąĮąŠą╣ čüąĖčüč鹥ą╝čŗ. ąØą░ą┐čĆąĖą╝ąĄčĆ, ąĖą╝ąĄčÅ ą▓čŗčüąŠą║ąŠą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮčŗą╣ ą╝ą░čüčüąĖą▓, ą┐ąŠą┤ą║ą╗čÄčćą░čÄčé ąĄą│ąŠ ą║ čüąĄčĆą▓ąĄčĆą░ą╝ ą▒ą░ąĘ ą┤ą░ąĮąĮčŗčģ ąĖ čäą░ą╣ą╗ąŠą▓ąŠą╝čā čüąĄčĆą▓ąĄčĆčā č湥čĆąĄąĘ SAN-čüąĄčéčī ąĖ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ą║ąŠąĮąĄčćąĮčŗčģ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĄą╣ ŌĆō ą║ čäą░ą╣ą╗ąŠą▓ąŠą╝čā čüąĄčĆą▓ąĄčĆčā č湥čĆąĄąĘ NAS, ą│ą┤ąĄ ąŠąĮąĖ ą╝ąŠą│čāčé čģčĆą░ąĮąĖčéčī čäą░ą╣ą╗čŗ ą┤ą╗čÅ ąŠą▒čēąĄą│ąŠ ą┤ąŠčüčéčāą┐ą░.

ąĪą░ą╝ąĖ ą╝ą░čüčüąĖą▓čŗ ąĘą░ ą▓čüčÄ ąĖčüč鹊čĆąĖčÄ ąĪąźąö čéą░ą║ąČąĄ ą┐čĆąĄč鹥čĆą┐ąĄą╗ąĖ ąĖąĘą╝ąĄąĮąĄąĮąĖčÅ ŌĆō ąŠčé ąŠą▒čŗčćąĮčŗčģ JBODŌĆÖąŠą▓ (Just a Bunch of Disks) ą┤ąŠ ąŠčéą║ą░ąĘąŠčāčüč鹊ą╣čćąĖą▓čŗčģ ą▓čŗčüąŠą║ąŠą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮčŗčģ čüąĖčüč鹥ą╝ čüąŠ čüą▓ąŠąĄą╣ OS. ą¤ąĄčĆą▓čŗąĄ JBODŌĆÖčŗ ą┤ą░ąČąĄ ąĮąĄ ąĖą╝ąĄą╗ąĖ ą║ą░ą║ąŠą╣-ą╗ąĖą▒ąŠ ąĖąĘą▒čŗč鹊čćąĮąŠčüčéąĖ. ą×ąĮąĖ čĆą░ą▒ąŠčéą░ą╗ąĖ ą║ą░ą║ ąŠą▒čŗčćąĮčŗąĄ IDE- ąĖą╗ąĖ ATA-ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆčŗ, ąŠčéą┤ą░ą▓ą░čÅ ą┤ąĖčüą║ąĖ "ą║ą░ą║ ąĄčüčéčī". ąĪąĄą╣čćą░čü ąČąĄ ą┤ą░ąČąĄ čüą░ą╝ąŠąĄ ą┐čĆąŠčüč鹊ąĄ čāčüčéčĆąŠą╣čüčéą▓ąŠ čüą┐ąŠčüąŠą▒ąĮąŠ čüąŠąĘą┤ą░ą▓ą░čéčī RAID ąĖąĘ ąĮąĄčüą║ąŠą╗čīą║ąĖčģ ą┤ąĖčüą║ąŠą▓.

ąĪąŠą▓čĆąĄą╝ąĄąĮąĮčŗąĄ ą╝ą░čüčüąĖą▓čŗ ą▓ ąŠčüąĮąŠą▓ąĮąŠą╝ ą┤ąĄą╗čÅčéčüčÅ ąĮą░ čéčĆąĖ ą║ą╗ą░čüčüą░: Entry-Level, Mid-Range ąĖ Hi-End. ą£ą░čüčüąĖą▓čŗ ą┐ąĄčĆą▓ąŠą│ąŠ, čüą░ą╝ąŠą│ąŠ ą┐čĆąŠčüč鹊ą│ąŠ, ą║ą╗ą░čüčüą░ ą╝ąŠą│čāčé čüąŠčüč鹊čÅčéčī ąĖąĘ ąĮąĄčüą║ąŠą╗čīą║ąĖčģ ą┤ąĖčüą║ąŠą▓ ąĖ ą▓ ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąĄ čüą▓ąŠąĄą╝ ąĮąĄ ą▓čŗčģąŠą┤čÅčé ąĘą░ čĆą░ą╝ą║ąĖ ąŠą┤ąĮąŠą╣ ą┐ąŠą╗ą║ąĖ čü čüąŠą▒čüčéą▓ąĄąĮąĮčŗą╝ ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆąŠą╝ ąĖą╗ąĖ ą▒ąĄąĘ ąĮąĄą│ąŠ. ąöą░ąĮąĮčŗą╣ ą║ą╗ą░čüčü ą╝ąĄąĮčīčłąĄ ą▓čüąĄą│ąŠ ą┐ąŠčéčĆąĄą▒ą╗čÅąĄčé 菹╗ąĄą║čéčĆąŠčŹąĮąĄčĆą│ąĖąĖ ąĖ čÅą▓ą╗čÅąĄčéčüčÅ čüą░ą╝čŗą╝ čéąĖčģąĖą╝. ąóą░ą║ąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ ą╝ąŠąČąĮąŠ ą┐ąŠčüčéą░ą▓ąĖčéčī ą┤ą░ąČąĄ čā čüąĄą▒čÅ ą┤ąŠą╝ą░ ąĖą╗ąĖ ą▓ ąŠčäąĖčüąĮąŠą╝ ą┐ąŠą╝ąĄčēąĄąĮąĖąĖ.

ąÆč鹊čĆąŠą╣ ą║ą╗ą░čüčü ą╝ą░čüčüąĖą▓ąŠą▓ ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░ąĄčé ą▒ąŠą╗ąĄąĄ ą▓čŗčüąŠą║ąĖą╣ čāčĆąŠą▓ąĄąĮčī: ą║ąŠą╝ą┐ąŠąĮąĄąĮčéčŗ ą╝ą░čüčüąĖą▓ą░ (ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆčŗ, 菹╗ąĄą╝ąĄąĮčéčŗ 菹╗ąĄą║čéčĆąŠą┐ąĖčéą░ąĮąĖčÅ ąĖ ą▓ąĄąĮčéąĖą╗čÅčåąĖąĖ) ą┤čāą▒ą╗ąĖčĆčāčÄčéčüčÅ, čćč鹊 ą┐ąŠą▓čŗčłą░ąĄčé 菹ĮąĄčĆą│ąŠą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ ąĖ čāčĆąŠą▓ąĄąĮčī čłčāą╝ą░ ąŠčé ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ. ąÆ čüą╗čāčćą░ąĄ ą▓čŗčģąŠą┤ą░ ąĖąĘ čüčéčĆąŠčÅ ąŠą┤ąĮąŠą│ąŠ ąĖąĘ ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆąŠą▓ čüąŠčģčĆą░ąĮčÅąĄčéčüčÅ ą┤ąŠčüčéčāą┐ ą║ ąĖąĮč乊čĆą╝ą░čåąĖąĖ, ąĮąŠ čćą░čēąĄ ą▓čüąĄą│ąŠ čāčéčĆą░čćąĖą▓ą░ąĄčéčüčÅ ą┐ąŠą╗ąŠą▓ąĖąĮą░ ą▒čŗčüčéčĆąŠą┤ąĄą╣čüčéą▓ąĖčÅ ąĖ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ.

ąóčĆąĄčéąĖą╣ ą║ą╗ą░čüčü ą╝ą░čüčüąĖą▓ąŠą▓ čüą░ą╝čŗą╣ ąĮą░ą┤ąĄąČąĮčŗą╣ ąĖ ą┐ąŠčéčĆąĄą▒ą╗čÅąĄčé ą▒ąŠą╗čīčłąĄ 菹ĮąĄčĆą│ąĖąĖ, č湥ą╝ ąŠčüčéą░ą╗čīąĮčŗąĄ. ąÆ ąĮąĄą╝ ą┤čāą▒ą╗ąĖčĆčāčÄčéčüčÅ ą░ą▒čüąŠą╗čÄčéąĮąŠ ą▓čüąĄ čćą░čüčéąĖ. ąöąĖčüą║ąĖ ąĖ ą┤čĆčāą│ąĖąĄ ą║ąŠą╝ą┐ąŠąĮąĄąĮčéčŗ, ąŠčéą▓ąĄčćą░čÄčēąĖąĄ ąĘą░ ąŠą▒čĆą░ą▒ąŠčéą║čā ąĖ ą┤ąŠčüčéą░ą▓ą║čā ąŠą┐ąĄčĆą░čåąĖą╣ ą▓ą▓ąŠą┤ą░-ą▓čŗą▓ąŠą┤ą░, ąĖą╝ąĄčÄčé ą┤ąŠčüčéčāą┐ ą║ ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆą░ą╝ ą╝ą░čüčüąĖą▓ą░ ą┐ąŠ ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ ą┐čāčéčÅą╝, čćč鹊 ą▓ąŠ ą╝ąĮąŠą│ąŠ čĆą░ąĘ ą┐ąŠą▓čŗčłą░ąĄčé ąŠčéą║ą░ąĘąŠčāčüč鹊ą╣čćąĖą▓ąŠčüčéčī ąĖ, čćč鹊 ąĮąĄ ą╝ąĄąĮąĄąĄ ą▓ą░ąČąĮąŠ, ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī. ą¤čĆąĖ ą▓čŗčģąŠą┤ąĄ ąĖąĘ čüčéčĆąŠčÅ ą╗čÄą▒ąŠą│ąŠ ąĖąĘ ą║ąŠą╝ą┐ąŠąĮąĄąĮč鹊ą▓ (ą▓ čé.čć. ą┤ąĖčüą║ą░, ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆą░) čüąĮąĖąČąĄąĮąĖąĄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ ąĮąĄąĘąĮą░čćąĖč鹥ą╗čīąĮąŠ. ąöą░ąĮąĮąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ ą╗čāčćčłąĄ ą▓čüąĄą│ąŠ čĆą░ąĘą╝ąĄčēą░čéčī ą▓ ą”ą×ąö, čéą░ą║ ą║ą░ą║ ąŠąĮąŠ ą╝ąŠąČąĄčé ąĘą░ąĮąĖą╝ą░čéčī ąĮąĄčüą║ąŠą╗čīą║ąŠ ąŠčéą┤ąĄą╗čīąĮčŗčģ čüč鹊ąĄą║.

ąöąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗąĄ čäčāąĮą║čåąĖąĖ ą╝ą░čüčüąĖą▓ąŠą▓, čéą░ą║ąĖąĄ ą║ą░ą║ ą╗ąŠą║ą░ą╗čīąĮą░čÅ ąĖą╗ąĖ čāą┤ą░ą╗ąĄąĮąĮą░čÅ čĆąĄą┐ą╗ąĖą║ą░čåąĖčÅ, č鹊ąĮą║ąŠąĄ ą▓čŗą┤ąĄą╗ąĄąĮąĖąĄ ą┤ąĖčüą║ąŠą▓ąŠą│ąŠ ą┐čĆąŠčüčéčĆą░ąĮčüčéą▓ą░ (Thin Provisioning), ą╝ąĮąŠą│ąŠčāčĆąŠą▓ąĮąĄą▓ąŠąĄ čģčĆą░ąĮąĄąĮąĖąĄ ą┤ą░ąĮąĮčŗčģ (Tiering), ą┤ąĄą┤čāą┐ą╗ąĖą║ą░čåąĖčÅ ąĖ ą║ąŠą╝ą┐čĆąĄčüčüąĖčÅ, čćą░čēąĄ ą▓čüąĄą│ąŠ ąĮą░čćąĖąĮą░čÄčé ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░čéčīčüčÅ čü Mid-Range-čāčĆąŠą▓ąĮčÅ. ąśą╝ąĄąĮąĮąŠ čŹčéąĖ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ą┐ąŠą▓čŗčłą░čÄčé čŹčäč乥ą║čéąĖą▓ąĮąŠčüčéčī čģčĆą░ąĮąĄąĮąĖčÅ ą┤ą░ąĮąĮčŗčģ ą┐čĆąĖ ąĖčģ ą┐ąŠčüč鹊čÅąĮąĮąŠą╝ čĆąŠčüč鹥. ą×ą▒ą╗ą░čćąĮčŗąĄ ą┐čĆąŠą▓ą░ą╣ą┤ąĄčĆčŗ ąĖąĘ čüąŠąŠą▒čĆą░ąČąĄąĮąĖą╣ ąĮą░ą┤ąĄąČąĮąŠčüčéąĖ ąĖ ą▓čŗčüąŠą║ąŠą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ ąŠą▒čŗčćąĮąŠ ą║ą░ą║ čĆą░ąĘ ąĖ ąĖčüą┐ąŠą╗čīąĘčāčÄčé ą╝ą░čüčüąĖą▓čŗ ą▓č鹊čĆąŠą│ąŠ ąĖ čéčĆąĄčéčīąĄą│ąŠ ą║ą╗ą░čüčüą░ čüąŠ ą▓čüąĄą╝ąĖ ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗą╝ąĖ čäčāąĮą║čåąĖčÅą╝ąĖ. ąØąĄą╝ą░ą╗ąŠąĄ ą┐čĆąĄąĖą╝čāčēąĄčüčéą▓ąŠ ąĘą░ą║ą╗čÄčćą░ąĄčéčüčÅ ą▓ č鹊ą╝, čćč鹊 ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąŠ ąĖąĘ ąĮąĖčģ čāą╝ąĄąĄčé ąŠčéą┤ą░ą▓ą░čéčī ąĖąĮč乊čĆą╝ą░čåąĖčÄ ą┐ąŠ ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ ą┐čĆąŠč鹊ą║ąŠą╗ą░ą╝ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ (FC, iSCSI, CIFS, NFS), čćč鹊 čüąŠą║čĆą░čēą░ąĄčé ąĘą░čéčĆą░čéčŗ ąĮą░ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčā, 菹║ąŠąĮąŠą╝ąĖčé čĆąĄčüčāčĆčüčŗ ąĖ čāą┐čĆąŠčēą░ąĄčé ą░ą┤ą╝ąĖąĮąĖčüčéčĆąĖčĆąŠą▓ą░ąĮąĖąĄ čüąĖčüč鹥ą╝čŗ ą▓ čåąĄą╗ąŠą╝.

ąØą░ č乊ąĮąĄ ąŠą▒čēąĄą│ąŠ čüąŠą║čĆą░čēąĄąĮąĖčÅ ą┐čĆąŠą┤ą░ąČ ąĪąźąö ą▓čüą╗ąĄą┤čüčéą▓ąĖąĄ ą┐ą░ą┤ąĄąĮąĖčÅ čüą┐čĆąŠčüą░ ąĮą░ čéčĆą░ą┤ąĖčåąĖąŠąĮąĮčŗąĄ ą┤ąĖčüą║ąŠą▓čŗąĄ čģčĆą░ąĮąĖą╗ąĖčēą░ čü ą║čĆčāčéčÅčēąĖą╝ąĖčüčÅ ąČąĄčüčéą║ąĖą╝ąĖ ą┤ąĖčüą║ą░ą╝ąĖ ą░ąĮą░ą╗ąĖčéąĖą║ąĖ IDC ąŠčéą╝ąĄčéąĖą╗ąĖ ą▓ ą┐ąĄčĆą▓ąŠą╝ ą┐ąŠą╗čāą│ąŠą┤ąĖąĖ 2017 ą│. ą▒čŗčüčéčĆčŗą╣ čĆąŠčüčé čüąĄą│ą╝ąĄąĮčéą░ flash-ą╝ą░čüčüąĖą▓ąŠą▓: ąŠčéą│čĆčāąĘą║ąĖ čüąĖčüč鹥ą╝, ą┐ąŠčüčéčĆąŠąĄąĮąĮčŗčģ č鹊ą╗čīą║ąŠ ąĮą░ ą╝ą░čüčüąĖą▓ą░čģ flash-ą┐ą░ą╝čÅčéąĖ, ą┐ąŠą┤čüą║ąŠčćąĖą╗ąĖ ąĮą░ 86,5% ą▓ ą┤ąĄąĮąĄąČąĮąŠą╝ ą▓čŗčĆą░ąČąĄąĮąĖąĖ ąĖ ą┤ąŠčüčéąĖą│ą╗ąĖ 23,7% ąŠčé čüčāą╝ą╝ą░čĆąĮčŗčģ. ąŁčéąĖ ą┤ą░ąĮąĮčŗąĄ ąĮąĄ čāą┤ąĖą▓ą╗čÅčÄčé, ą▓ąĄą┤čī ą┐ąŠ čåąĄąĮąĄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮčŗąĄ SSD-ą┤ąĖčüą║ąĖ ą┐čĆą░ą║čéąĖč湥čüą║ąĖ čüčĆą░ą▓ąĮčÅą╗ąĖčüčī čü ą┤ąĖčüą║ą░ą╝ąĖ SAS 15k, ą░ ą┐ąŠ ą▒čŗčüčéčĆąŠą┤ąĄą╣čüčéą▓ąĖčÄ flash-ąĮą░ą║ąŠą┐ąĖč鹥ą╗ąĖ ą▓čŗąĖą│čĆčŗą▓ą░čÄčé ą▓ąŠ ą╝ąĮąŠą│ąŠ čĆą░ąĘ. ąŁč鹊 ąĖ čüčéą░ą╗ąŠ čĆąĄčłą░čÄčēąĖą╝ čäą░ą║č鹊čĆąŠą╝ ą┐čĆąĖ ą▓čŗą▒ąŠčĆąĄ SSD ą┤ą╗čÅ ą▓čŗčüąŠą║ąŠą║čĆąĖčéąĖčćąĮčŗčģ ą▒ąĖąĘąĮąĄčü-čüąĖčüč鹥ą╝.

ąĀą░ą▒ąŠčéą░čÅ ąĮą░ čĆčŗąĮą║ąĄ ąŠą▒ą╗ą░čćąĮčŗčģ čüąĄčĆą▓ąĖčüąŠą▓, ą▓ čüąĖčéčāą░čåąĖąĖ ą░ąĮą░ą╗ąŠą│ąĖčćąĮąŠą│ąŠ ą▓čŗą▒ąŠčĆą░ ą║ąŠąĮąĄčćąĮąŠ ąČąĄ, ą╗čāčćčłąĄ čüą┤ąĄą╗ą░čéčī ąĄą│ąŠ ą▓ ą┐ąŠą╗čīąĘčā SSD-ąĮą░ą║ąŠą┐ąĖč鹥ą╗ąĄą╣. ą×čüąĮąŠą▓ąĮčŗąĄ ą╝ą░čüčüąĖą▓čŗ čĆą░ą▒ąŠčéą░čÄčé ąĮą░ flash-ąĮą░ą║ąŠą┐ąĖč鹥ą╗čÅčģ, čü ą▓ą║ą╗čÄč湥ąĮąĮčŗą╝ąĖ ą┐ąŠą╗ąĖčéąĖą║ą░ą╝ąĖ QoS ąĮą░ LUNŌĆÖą░čģ. ąŁč鹊 ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ą▒ąŠą╗ąĄąĄ ą│ąĖą▒ą║ąŠ ą┐ąŠą┤čģąŠą┤ąĖčéčī ą║ ą░ą┤ą╝ąĖąĮąĖčüčéčĆąĖčĆąŠą▓ą░ąĮąĖčÄ ą╝ą░čüčüąĖą▓ąŠą▓ ąĖ ą▓čŗą┤ąĄą╗čÅčéčī ą║ą╗ąĖąĄąĮčéą░ą╝ ą│ą░čĆą░ąĮčéąĖčĆąŠą▓ą░ąĮąĮčāčÄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī ą▒ąĄąĘ ą▓ą╗ąĖčÅąĮąĖčÅ ąĮą░ "čüąŠčüąĄą┤ąĄą╣".

ą¤ąŠą╝ąĖą╝ąŠ ą║ą╗ą░čüčüąĖč湥čüą║ąĖčģ ąĪąźąö, ą▓čüąĄ ą▒ąŠą╗čīčłčāčÄ ą┐ąŠą┐čāą╗čÅčĆąĮąŠčüčéčī ąĮą░ą▒ąĖčĆą░čÄčé SDS-čĆąĄčłąĄąĮąĖčÅ (Software Defined Storage, ą┐čĆąŠą│čĆą░ą╝ą╝ąĮąŠ-ąŠą┐čĆąĄą┤ąĄą╗čÅąĄą╝čŗąĄ ąĪąźąö). ą¤ąŠ ą┐čĆąŠą│ąĮąŠąĘą░ą╝ Gartner, ą║ 2020 ą│. 70ŌĆō80% ąĮąĄčüčéčĆčāą║čéčāčĆąĖčĆąŠą▓ą░ąĮąĮčŗčģ ą┤ą░ąĮąĮčŗčģ ą▒čāą┤čāčé čģčĆą░ąĮąĖčéčīčüčÅ ąĮą░ ąĮąĄą┤ąŠčĆąŠą│ąĖčģ čüąĖčüč鹥ą╝ą░čģ, čāą┐čĆą░ą▓ą╗čÅąĄą╝čŗčģ čü ą┐ąŠą╝ąŠčēčīčÄ SDS. ąÆ čéą░ą║ąĖčģ čüąĖčüč鹥ą╝ą░čģ ą┐čĆą░ą║čéąĖč湥čüą║ąĖ ą▓čüčÅ čĆą░ą▒ąŠčéą░ ą┐ąŠ čĆą░čüą┐čĆąĄą┤ąĄą╗ąĄąĮąĖčÄ ą┤ą░ąĮąĮčŗčģ ą┤ąĄą╗ąĄą│ąĖčĆčāąĄčéčüčÅ čüąŠčäčéčā, ą░ ą┐ąŠą┤ ąĮąĖą╝ ą╝ąŠąČąĄčé ąĮą░čģąŠą┤ąĖčéčīčüčÅ ą╗čÄą▒ąŠąĄ čäąĖąĘąĖč湥čüą║ąŠąĄ čģčĆą░ąĮąĖą╗ąĖčēąĄ, ą▒čāą┤čī č鹊 ąŠą▒čŗčćąĮčŗą╣ ą┤ąĖčüą║ ąĖą╗ąĖ ą╝ą░čüčüąĖą▓.

ąĢčüą╗ąĖ čā ą▓ą░čü ą▒ąŠą╗čīčłąŠą╣ ą┐ą░čĆą║ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ, ą║ąŠč鹊čĆčŗą╣ ą▓ą║ą╗čÄčćą░ąĄčé ą╝ą░čüčüąĖą▓čŗ ąŠčé čĆą░ąĘąĮčŗčģ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗ąĄą╣, č鹊 ą┤ą╗čÅ ą▒ąŠą╗ąĄąĄ ą│ąĖą▒ą║ąŠą│ąŠ ąĖ čāą┤ąŠą▒ąĮąŠą│ąŠ ą░ą┤ą╝ąĖąĮąĖčüčéčĆąĖčĆąŠą▓ą░ąĮąĖčÅ čéą░ą║ąŠą╣ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ ąĖčģ ą╝ąŠąČąĮąŠ ą┐ąŠą┤ą▓ąĄčüčéąĖ ą┐ąŠą┤ SDS. ąŁč鹊 ą┐ąŠąĘą▓ąŠą╗ąĖčé ąŠą┐čéąĖą╝ąĖąĘąĖčĆąŠą▓ą░čéčī ą┐čĆąŠčåąĄą┤čāčĆčā ą▓čŗą┤ąĄą╗ąĄąĮąĖčÅ čĆąĄčüčāčĆčüąŠą▓ čüąŠ ą▓čüąĄčģ ą╝ą░čüčüąĖą▓ąŠą▓, ą░ čéą░ą║ąČąĄ ąĖą╝ąĄčéčī ąĄą┤ąĖąĮčāčÄ "ą║ąŠąĮčüąŠą╗čī" ą┤ą╗čÅ ąŠą┐ąĄčĆą░čåąĖą╣. ąĢčüą╗ąĖ čā ą▓ą░čü čüčéą░čĆąŠąĄ ąČąĄą╗ąĄąĘąŠ ąĖ čģąŠč湥čéčüčÅ ą┤ą░čéčī ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÄ "ą▓č鹊čĆčāčÄ ąČąĖąĘąĮčī", ąĘą┤ąĄčüčī č鹊ąČąĄ ą┐ąŠą╝ąŠąČąĄčé SDS.

ąĪą╝ąŠą│čāčé ą╗ąĖ ą┐čĆąŠą│čĆą░ą╝ą╝ąĮąŠąŠą┐čĆąĄą┤ąĄą╗čÅąĄą╝čŗąĄ ąĪąźąö ą┐ąŠą╗ąĮąŠčåąĄąĮąĮąŠ ąĘą░ą╝ąĄąĮąĖčéčī ą║ą╗ą░čüčüąĖč湥čüą║ąĖąĄ čüąĖčüč鹥ą╝čŗ? ąÜą░ąČą┤čŗą╣ ąĮą░ čŹč鹊čé ą▓ąŠą┐čĆąŠčü ąŠčéą▓ąĄčéąĖčé ą┤ą╗čÅ čüąĄą▒čÅ čüą░ą╝. ąĪąŠą│ą╗ą░čüąĮčŗ ą╗ąĖ ą▓čŗ ą╝ąĖčĆąĖčéčīčüčÅ čü ąĄčēąĄ ąŠą┤ąĮąŠą╣ "ą┐čĆąŠčüą╗ąŠą╣ą║ąŠą╣" ą╝ąĄąČą┤čā ą╝ą░čüčüąĖą▓ąŠą╝ ąĖ čüąĄčĆą▓ąĄčĆąŠą╝? ąĢčüčéčī ą╗ąĖ ą│ąŠč鹊ą▓ąĮąŠčüčéčī ąĖ čüąĖą╗čŗ ąŠčéą║ą░ąĘą░čéčīčüčÅ ąŠčé "ą║ą╗ą░čüčüąĖč湥čüą║ąŠą╣ ą┐čĆąĄą┤čüą║ą░ąĘčāąĄą╝ąŠčüčéąĖ" ąŠą▒čŗčćąĮčŗčģ ą╝ą░čüčüąĖą▓ąŠą▓? ąöą╗čÅ ą║ą░ą║ąĖčģ ą║ąŠąĮą║čĆąĄčéąĮčŗčģ čåąĄą╗ąĄą╣ ą▓čŗ ą▓čŗą▒ąĖčĆą░ąĄč鹥 ąĖą╝ąĄąĮąĮąŠ čŹčéčā č鹥čģąĮąŠą╗ąŠą│ąĖčÄ? ąĪą║ąŠą╗čīą║ąŠ ą▓čŗ ą│ąŠč鹊ą▓čŗ ą┐ąŠčéčĆą░čéąĖčéčī ąĮą░ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčā? ąØą░ čŹčéąĖ ąĖ ą╝ąĮąŠą│ąĖąĄ ą┤čĆčāą│ąĖąĄ ą▓ąŠą┐čĆąŠčüčŗ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ ąŠčéą▓ąĄčéąĖčéčī, ą┐čĆąĄąČą┤ąĄ č湥ą╝ ą┤ąĄą╗ą░čéčī ą▓čŗą▓ąŠą┤čŗ.

ąÜą░ą║ą░čÅ ąĖąĘ ąŠą┐ąĖčüą░ąĮąĮčŗčģ čüąĖčüč鹥ą╝ ąŠą║ą░ąČąĄčéčüčÅ ą▓ ą╗ąĖą┤ąĄčĆą░čģ ą▓ ą▒ą╗ąĖąČą░ą╣čłąĄą╝ ą▒čāą┤čāčēąĄą╝, čüą║ą░ąĘą░čéčī čüą╗ąŠąČąĮąŠ, ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąŠ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ ą╝ąĄąĮčÅąĄčéčüčÅ ą│ąŠą┤ ąŠčé ą│ąŠą┤ą░. ą×ą┤ąĮą░ą║ąŠ ąŠč湥ą▓ąĖą┤ąĮąŠ, čćč鹊 ą▓ ąĀąŠčüčüąĖąĖ čĆčŗąĮąŠą║ ąĪąźąö ą▒čāą┤ąĄčé ąĮąĄčāą║ą╗ąŠąĮąĮąŠ čĆą░čüčéąĖ ŌĆō ąĮąĄ č鹊ą╗čīą║ąŠ ąĖąĘ-ąĘą░ ą▓čüąĄąŠą▒čŖąĄą╝ą╗čÄčēąĄą╣ čåąĖčäčĆąŠą▓ąĖąĘą░čåąĖąĖ, ąĮąŠ ąĖ ąĖąĘ-ąĘą░ ąĘą░ą║ąŠąĮą░ ą»čĆąŠą▓ąŠą╣ ąĖ ą┤čĆčāą│ąĖčģ ą░ą║č鹊ą▓, ąŠą▒čÅąĘčŗą▓ą░čÄčēąĖčģ čģčĆą░ąĮąĖčéčī ą┐ąĄčĆčüąŠąĮą░ą╗čīąĮčŗąĄ ą┤ą░ąĮąĮčŗąĄ č鹊ą╗čīą║ąŠ ąĮą░ č鹥čĆčĆąĖč鹊čĆąĖąĖ čüčéčĆą░ąĮčŗ.

ąøąĖč鹥čĆą░čéčāčĆą░

ą×ą┐čāą▒ą╗ąĖą║ąŠą▓ą░ąĮąŠ: ą¢čāčĆąĮą░ą╗ "ąóąĄčģąĮąŠą╗ąŠą│ąĖąĖ ąĖ čüčĆąĄą┤čüčéą▓ą░ čüą▓čÅąĘąĖ" #5, 2017

ą¤ąŠčüąĄčēąĄąĮąĖą╣: 2422

ąĪčéą░čéčīąĖ ą┐ąŠ č鹥ą╝ąĄ

ąÉą▓č鹊čĆ

| |||

ąÆ čĆčāą▒čĆąĖą║čā "ąĀąĄčłąĄąĮąĖčÅ ą║ąŠčĆą┐ąŠčĆą░čéąĖą▓ąĮąŠą│ąŠ ą║ą╗ą░čüčüą░" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣