В рубрику "Решения корпоративного класса" | К списку рубрик | К списку авторов | К списку публикаций

Встатье рассматривается влияние различных механизмов виртуализации на организацию хранения данных на различных уровнях стека вычислительных ресурсов: начиная от уровня локального сервера и заканчивая уровнем центра обработки данных.

This article looks at the different layers of storage virtualization – from dedicated server to data-center and cloud.

Виртуализация различных аппаратных ресурсов в вычислительных системах используется уже очень давно. Сам термин "виртуализация" можно определить как предоставление набора вычислительных ресурсов или их логического объединения, абстрагированное от аппаратной реализации. В этом определении ключевым является момент абстрагирования, т.е. виртуализация – это лишь механизм, обеспечивающий удобную форму предоставления ресурсов определенной составляющей всего стека по запросам других его составляющих.

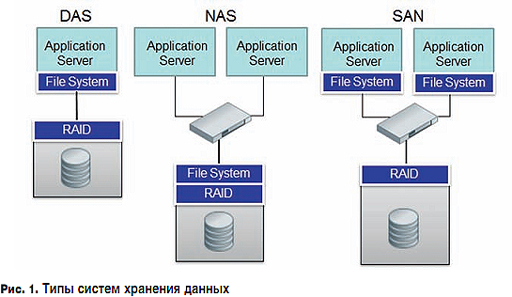

Виртуализация хранения данных может быть реализована на разных уровнях, но во всех случаях тип, количество и организация систем хранения – все это остается для администратора сервера "за кадром". Для серверов видны только выделенные им дисковые тома, независимо от того, на каких системах хранения они находятся и как организованы. Такой подход заметно упрощает администрирование самих серверов, но виртуализация в системах хранения данных позволяет упростить и решение очень многих других задач. Виртуализация в подсистемах хранения данных (дисковых подсистемах серверов) появилась задолго до виртуализации вычислительных ресурсов (процессоров), правда, в те времена никто это виртуализацией не называл, ведь, по сути своей, даже создание RAID-массива и выделение на нем пространства под логический том уже является виртуализацией, так как скрывает фактическую организацию дискового пространства от операционной системы сервера. Это здорово упрощает жизнь администратору сервера, так как RAID-контроллер позволяет получать логические диски большего объема, чем физические диски, установленные в сервер. Кроме этого, контроллер снижает нагрузку на процессор сервера, решая задачи кеширования данных при чтении и записи, защиты данных путем создания RAID-групп и их восстановления при сбое одного или нескольких дисков. Такой способ организации системы хранения получил название Direct Attached Storage (DAS), т.е. системы хранения с прямым подключением к серверу. Главный недостаток таких систем виден из их определения – невозможность подключения к более чем одному–двум серверам и функциональная ограниченность RAID-контроллера.

Следующим шагом в процессе виртуализации хранения данных стало выделение локальной дисковой подсистемы сервера в отдельное устройство – систему хранения данных (СХД). Создание СХД позволило не только отделить физическое представление дисков от логического, но и добавить ряд важнейших функций, позволяющих повысить надежность хранения данных вплоть до уровня "5 девяток" и удобство управления ресурсами хранения. По сути, СХД превратились в самостоятельный класс устройств, взяв на себя не только решение задачи надежного хранения данных за счет формирования дисковых RAID-групп и введения избыточности для всех модулей системы, но и смежные задачи:

И самое главное, СХД позволяют консолидировать все ресурсы хранения в одном месте, что значительно снижает операционные расходы на управление данными и упрощает их защиту, например архивирование и/или репликацию на резервную технологическую площадку. Такие выделенные СХД получили название сетей хранения – Storage Area Networks (SAN) и систем хранения с подключением по сети – Network Attached Storage (NAS). Традиционно к SAN относятся СХД с блочным доступом к данным, а к NAS – c файловым. Тем не менее, в настоящий момент почти все вендоры выпускают универсальные СХД, которые предоставляют как блочный, так и файловый доступ.

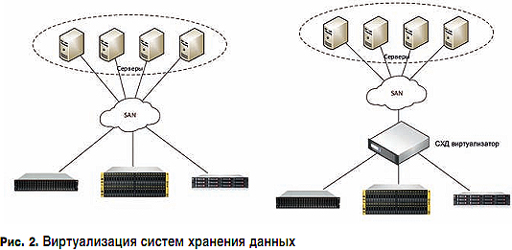

Еще более высоким уровнем виртуализации хранения является виртуализация нескольких систем хранения данных и объединение их в одну систему. Такая задача может возникнуть в случае, когда в компании уже имеется несколько СХД, и требуется дальнейшее увеличение дискового пространства. В результате того, что регулярно осуществляются закупки нового оборудования, а также после нескольких слияний используются дисковые системы различных поколений и производителей. Эффективное использование такого парка оборудования вызывает существенные трудности, администраторам требуется уметь управлять совершенно различными системами, и, как следствие, растут затраты на обслуживание. Решением этой проблемы является внедрение виртуализации СХД, когда одна из систем становится виртуализатором других, т.е. единой точкой "входа" для серверов, а остальные системы для нее выглядят обычными дисковыми ресурсами.

Это значительно упрощает решение следующих задач:

За годы работы IT-департаменты организаций вынуждены были приобретать различные типы технологических компонент, предназначенных для решения частных проблем в уже существующих системах. Например, системы кеширования на SSD внедрялись для повышения производительности систем хранения данных, WAN-ускорители – для более быстрой передачи данных по сети Интернет, дедупликация в системах резервного копирования – из-за быстрого роста сохраняемых данных и т.д. Каждый раз, когда добавляется новый компонент, – увеличивается сложность всей системы, что приводит к повышению расходов на IT и создает еще больший раскол между IT и бизнесом. Более того, комплексная защита данных и их послеаварийное восстановление остаются пока еще недостижимыми целями для многих, особенно не очень крупных организаций. Эти процессы зачастую требуют специального оборудования и программного обеспечения, что означает еще большее увеличение сложности IT-инфраструктуры и дополнительные расходы на обслуживание.

Тем не менее, в последние несколько лет наблюдается крупный переворот на рынке информационных технологий, в частности для тех производителей, которые создают технологии, ориентированные на центры обработки данных. Для этого переворота появился даже специальный термин – гиперконвергентная инфраструктура.

Это быстрорастущий класс решений, которые устраняют необходимость в наличии выделенных систем хранения в ЦОДах и в некоторых случаях других устройств, таких как, например, сетевые маршрутизаторы, брандмауэры, балансировщики нагрузки. Это, конечно, не означает, что системы хранения данных больше не являются важной частью ЦОДа. На самом деле гиперконвергентные решения появились из-за того, что организации сталкиваются со значительными сложностями при эксплуатации уже существующих СХД. В последние годы потребности бизнеса стали намного превосходить возможности обычных СХД по увеличению емкости и производительности. Их сложность и стоимость растет непропорционально увеличению их емкости и производительности. Известно, что такие сервисы, как виртуализация рабочих столов и анализ данных требуют значительной производительности СХД, но даже базовые сервисы уже требуют увеличения производительности систем хранения, так как компании постоянно расширяют список виртуализированных сервисов и включают в него такие "тяжелые" приложения, как ERP, Microsoft Exchange, Microsoft SQL Server, Oracle и т.п.

В то же время руководители IT-подразделений постоянно работают над тем, чтобы IT-сервисы максимально полно соответствовали потребностям бизнеса. С течением времени ЦОДы превратились в сложнейшие структуры, требующие отдельных подразделений для обслуживания и поддержания их в рабочем состоянии. Чем сложнее становятся системы, тем больше требуется сотрудников для их обслуживания и тем больше расходы организации на IT в целом.

Гиперконвергентная инфраструктура была разработана, чтобы решить проблемы производительности, масштабирования, сложности и стоимости, которые преследуют IT с расширением бизнеса. Эти системы возвращают IT к парадигме DAS, а точнее, к концепции использования в качестве подсистемы хранения локальных дисков сервера, но многие решения значительно расширяют эту парадигму новыми возможностями. Такие системы строятся на базе стандартных серверов с установленным на них традиционным гипервизором, но дополнительно применяется специальное ПО, поставляемое производителем гиперконвергентного решения. Есть разработчики, которые дополняют свои решения функциями дедупликации и сжатия данных, оптимизации WAN-каналов, защиты данных и шлюзами коблачным сервисам.

На базовом уровне данное ПО объединяет дисковые подсистемы всех узлов в единый пул и предоставляет этот пул гипервизору как общее дисковое пространство для использования виртуальными машинами. В сущности, гиперконвергентная инфраструктура использует концепцию программно-определяемых систем хранения (Software-Defined Storage – SDS).

Международная ассоциация производителей систем хранения данных SNIA (Storage Networking Industry Association) определяет SDS так: "Виртуализированное хранилище с интерфейсом управления сервисами. SDS включает в себя пулы хранения с определяемыми характеристиками, соответствующими требованиям, заданным с помощью интерфейса управления сервисом". И это больше, чем просто виртуализация хранения данных, так как SDS, по версии SNIA, должно предоставлять пользователям пулы хранения с заданными характеристиками и выполнять следующие функциональные требования:

И хотя разные вендоры понимают термин "программно-определяемое хранилище" по-разному, практически все ведущие производители СХД заявили о разработке подобных продуктов и активно работают в этом направлении. Переход к программно-определяемым системам открыл рынок СХД и для разработчиков ПО, которые никогда не занимались аппаратными системами хранения. Более того, одна из ведущих компаний-производителей предложила термин "программно-определяемый дата-центр" для описания более широкой концепции, в которой все виртуализированные хранилища, серверы, сетевые ресурсы и ресурсы безопасности, необходимые приложениям, могут быть определены программным обеспечением и выделены автоматически по запросу пользователя.

Таким образом, гиперконвергентную инфраструктуру можно определить как решение, объединяющее несколько сервисов центра обработки данных в одном устройстве, что повышает скорость разворачивания и гибкость виртуализированных приложений, уменьшает сложность инфраструктуры, улучшает эффективность управления и снижает общие затраты на эксплуатацию.

Основными движущими силами рынка виртуализации и гиперконвергентных решений можно назвать следующие ключевые факторы:

Общий уровень виртуализации всех ресурсов в ЦОДах достиг такого значения, что администраторы информационных систем могут вообще не задумываться об их физической организации и оперировать в терминах качества сервиса – получать требуемый ресурс c заданными характеристиками по требованию из частного или публичного облака. Более того, само понятие облака становится размытым, так как локальные ресурсы могут взаимодействовать с ресурсами, расположенными на площадках провайдеров инфраструктуры (IaaS).

Литература

Опубликовано: Журнал "Технологии и средства связи" #5, 2016

Посещений: 5607

Автор

| |||

В рубрику "Решения корпоративного класса" | К списку рубрик | К списку авторов | К списку публикаций